Привет. Сегодня вы узнаете как правильно составить файл robots txt для любого сайта! Файл robots txt необходим для эффективной индексации сайта, чтобы нужные страницы попадали в поиск, а не нужные не попадали в поиск. Начать хочу с того, что я не рекомендую копировать файл robots txt с других сайтов. Почему? Потому что данный файл нужно создавать непосредственно для каждого сайта, исходя из его настроек и параметров.

Конечно можно тупо скопировать робота с другого сайта, но тогда вы не будете контролировать индексацию своего сайта на 100%. Вы что-то упустите, а это что-то может оказаться чем-то серьёзным, что может навредить продвижению вашего сайта. Поэтому, далее я расскажу и покажу как самостоятельно составить правильный файл robots txt именно для своего сайта.

Принцип работы составления файла robots.txt

Зайдите на свой сайт, откройте любую запись, с помощью правой кнопки мыши перейдите в исходный код страницы. Смотрите, вам нужно проверить каждую ссылку, которая отображается в исходном коде и решить, закрывать её от индексации или нет. Тут всё очень просто, для поиска нам нужна только основная ссылка записи. Все остальные ссылки можно закрывать в файле robots txt.

Исходящие ссылки, то есть не ваши, например от рекламы, конечно закрывать в robots txt не надо, ничего это не даст и в этом нет смысла. Закрывать от индексации нужно только ссылки со своим доменным именем. Например — /wp-admin/, /wp-content/, /wp-includes/, /wp-json/, /page/ (ссылки админ-панели, ссылки пагинации и т.д.).

Таким образом вам нужно просмотреть исходный код страниц — записи, страницы, блога, категории. Все ссылки с вашим доменным именем, кроме основной ссылки страницы, нужно закрыть от индексации, потому что в поиске такие ссылки не нужны.

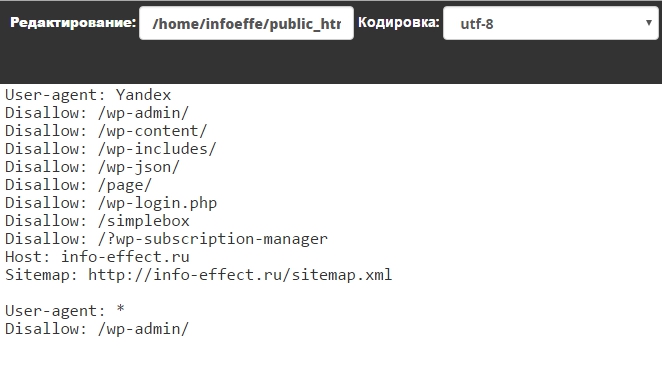

Мой файл robots txt

Сейчас поясню. Для Яндекса:

wp — здесь думаю всё понятно, закрываем ссылки админ-панели.

page — страницы пагинации, /page/1, /page/2, /page/3 и т.д. Такие страницы можно скрыть с помощью плагина.

Всё остальное ссылки скриптов и прочий не нужный мусор.

Host — показываем поиску наш основной домен. Обязательно указывать данную директиву для сайтов, у которых два адреса сайта с www и без.

Sitemap — ссылка на карту сайта sitemap для поисковых систем. Если не используете Sitemap, то соответственно не нужно указывать.

Директивы Host и Sitemap указываются только для Яндекс. Для Google нет смысла указывать, не читает он их в robots txt. В Google Вебмастер нужно указывать.

Для Google ничего закрывать не надо, кроме wp-admin. Почему ? Потому что Google блокирует страницы и записи, в которых есть ссылки закрытые в robots txt. Google использует robots txt только в качестве запрета сканирования страниц. Для Google закрывать страницы и записи от индексации нужно другим образом, с помощью плагинов или мета тегов.

Вот и всё, на самом деле всё очень просто здесь, просто разобраться надо!

Остались вопросы? Напиши комментарий. Удачи.